1. Zusammenfassung

📄 Download: PDF Version dieses Artikels

Zwei Tage zwischen KI-Euphorie und Realitätscheck – was ich über Amazon Bedrock, Agents und die Zukunft der Entwicklung gelernt habe.

Figure 1: Besuch des AWS Summit 2025 in Hamburg

Das AWS Summit Hamburg 2025 war mehr als nur eine regionale Tech-Konferenz – es war ein Fenster in die rasante Entwicklung der generativen KI-Landschaft. Als zertifizierter Cloud Solution Architect, der das letzte Jahr intensiv mit verschiedenen Aspekten von generativer KI verbracht hat, bot mir diese zweitägige Veranstaltung mit etwa 5.000 Teilnehmern eine einzigartige Gelegenheit, den aktuellen Stand der Technologie und deren Verbreitung in der Industrie zu bewerten.

Besonders aufgefallen ist mir: Ein Drittel aller 178 Sessions (60 Stück) beschäftigte sich mit generativer KI. Dies zeigt nicht nur die Dominanz des Themas, sondern auch, wie tief diese Technologie bereits in Unternehmen eingedrungen ist. Gleichzeitig half mir die Konferenz dabei, mein eigenes Open-Source-Projekt – ein datensparsames Chat-Client-Deployment – in den Kontext der industriellen Relevanz einzuordnen.

Während viele große Unternehmen bereits tiefgreifend mit generativer KI arbeiten, gibt es noch immer viele Organisationen ohne klare KI-Strategie. Genau hier wird die Relevanz meines Private-AI-Projekts deutlich.

2. Die Keynote: Fundamentale Innovation trifft auf praktische Anwendung

Die Keynote war, wie bei AWS üblich, eine umfassende Schaustellung technologischer Fortschritte. Interessant waren nicht nur die offensichtlichen KI-Features, sondern auch die grundlegenden Infrastrukturdienste, die diese Innovation erst ermöglichen.

Die weltweite Zeitsynchronisation der Computer im Millisekundenbereich mag auf den ersten Blick unspektakulär erscheinen, ist aber die Basis für viele andere Services und ermöglicht globale Datensynchronisation. Solche Details zeigen, wie durchdacht AWS seine Plattform entwickelt.

Besonders interessant waren die Kundengeschichten: Hapag Lloyd demonstrierte, wie AWS-Services und generative KI den Prozess des Kaffeetransports rund um die Welt unterstützen. Trellix, ein Cybersecurity-Unternehmen, zeigte ausgefeilte Bedrock-RAG-Implementierungen für strukturierte Datenanalyse. Die deutsche Bundesliga DFL Digital Sports setzt KI ein, um auf veränderte Nutzergewohnheiten zu reagieren und Fans mit Match-Facts-Anwendungen wie Torwahrscheinlichkeiten oder Schussgeschwindigkeiten einzubinden.

Ein Seitenhieb gegen die Konkkurenz war die Präsentation KI-unterstützter Migrationswerkzeuge für Microsoft .NET-Anwendungen und VMware-Workloads zur Kostensenkung bei Lizenzen. Besonders relevant für VMware-Kunden, die nach Broadcoms umstrittener Lizenzmodell-Änderung Ende 2023 nach Alternativen suchen.

3. Housewarming: Praxisnahe Workshops mit Lernkurve

Der Auftakt am ersten Tag bei Freenet und Moia war aufschlussreich, auch wenn nicht alles optimal lief. Die Workshops zu Bedrock Agents und Amazon Q Developer waren inhaltlich interessant, aber so getaktet, dass für den gewünschten Austausch mit anderen Kunden kaum Zeit blieb. Keine Pausen, keine Gelegenheit für spontane Gespräche – eine verpasste Networking-Chance.

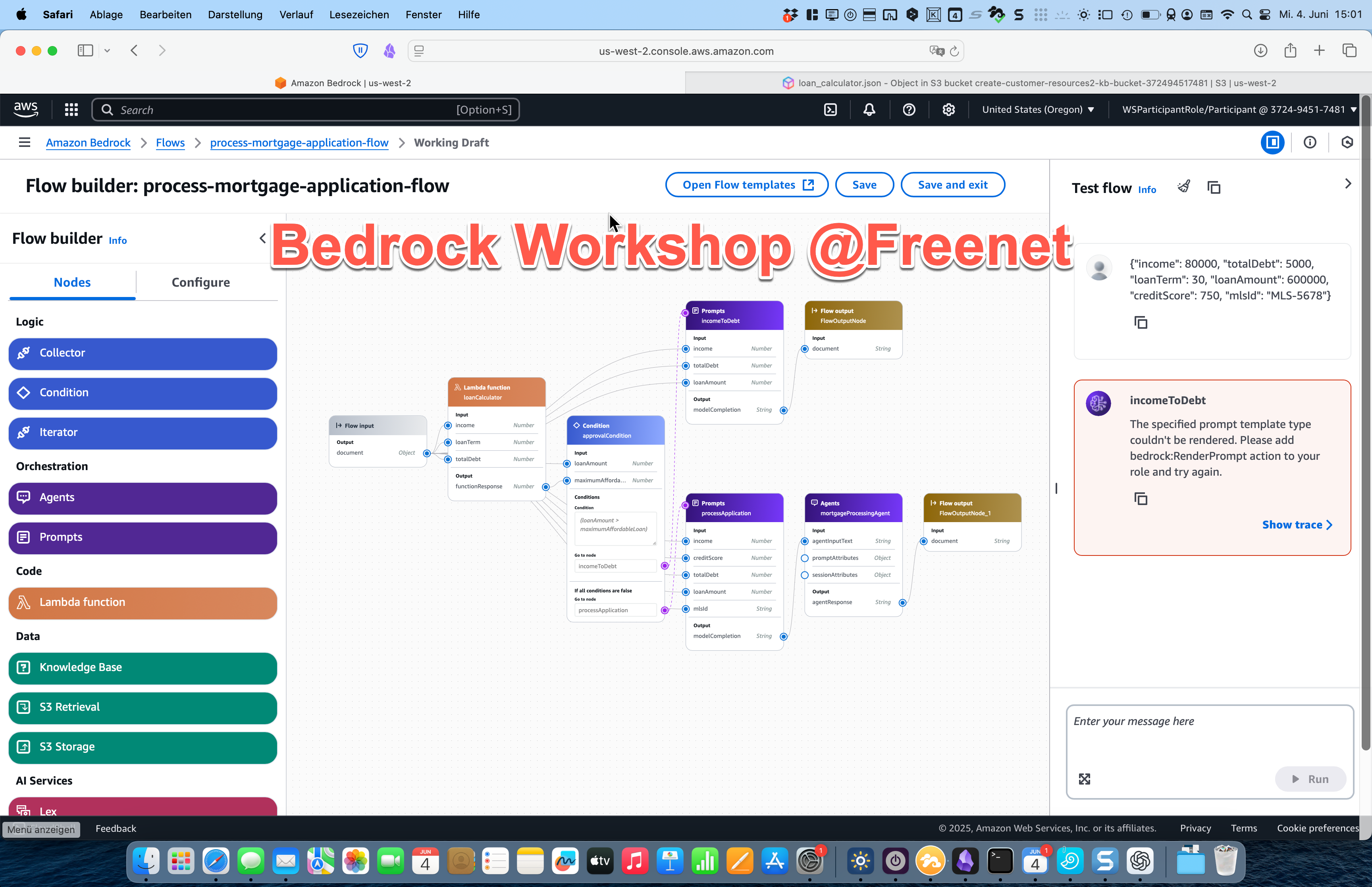

Der AWS Flow Builder funktioniert gut: Mit dieser grafischen Oberfläche lassen sich Agents für generative KI orchestrieren. Allerdings muss man auch die Kehrseite sehen – Amazon forciert damit einen gewissen Vendor-Lock-in, auch wenn die Innovationskraft unbestreitbar ist.

Figure 2: Bedrock Flow Builder bei einem Workshop in den Räumen der Freenet Group in Hamburg.

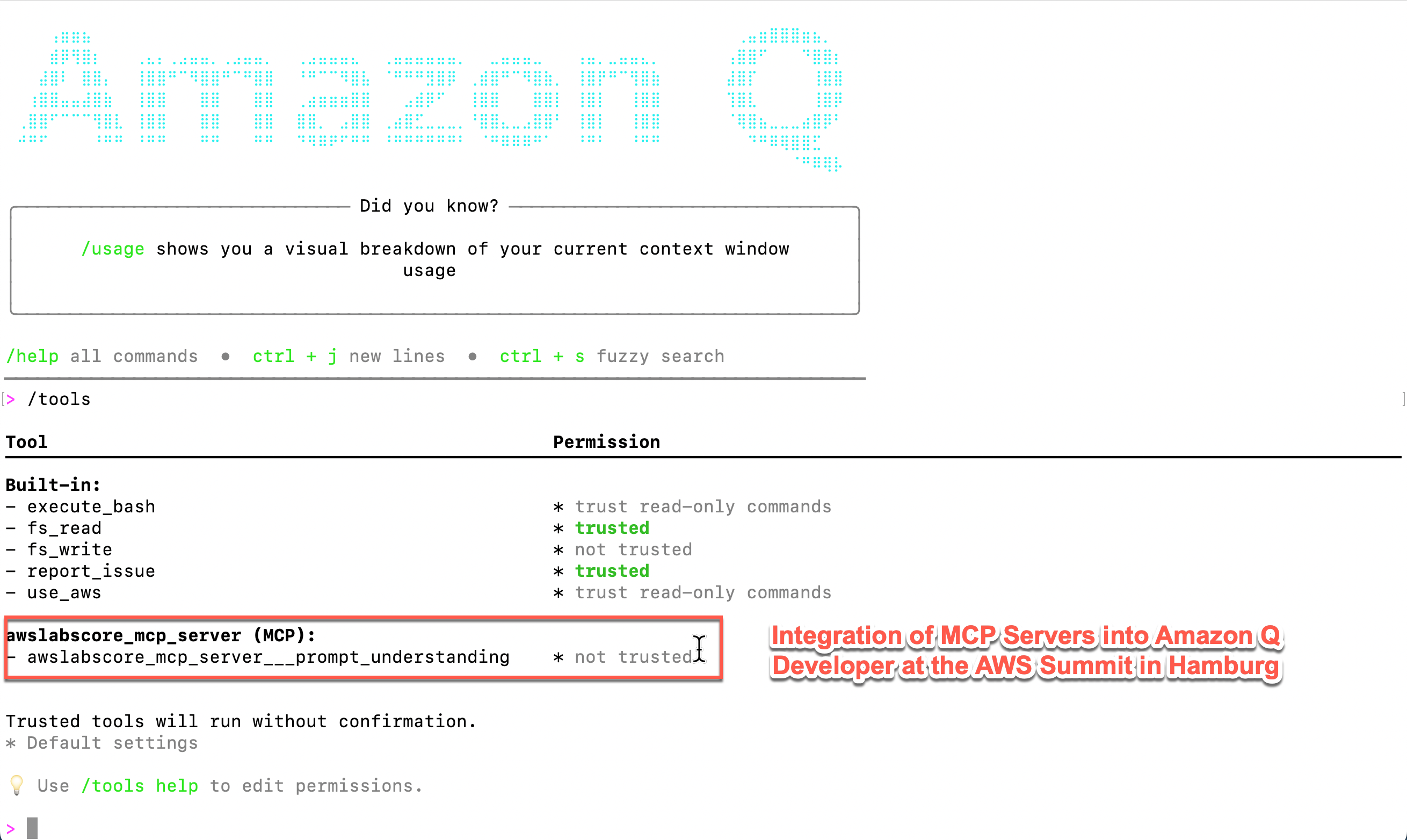

Bei Moia wurde Amazon Q Developer als Alternative zu GitHub Copilot und Claude Code präsentiert. Das wirklich Spannende war die Integration von MCP-Servern (Model Context Protocol), die die Fähigkeiten dieser Code-Assistenten erheblich erweitern. In nur 30 Minuten konnte ich mit Trainerunterstützung einen MCP-Server konfigurieren, der meine S3-Buckets analysierte und eine Grafik erstellte. Diese Geschwindigkeit war beeindruckend und zeigt das Potenzial dieser Technologie.

4. Das Herzstück: Agents und RAG im Produktionseinsatz

Im Zentrum der technischen Sessions standen Multi-Agenten-Systeme und Retrieval Augmented Generation (RAG). Diese Technologien sind bereits bei sehr vielen großen Kunden im Produktionseinsatz – meist vollständig selbst entwickelt unter Verwendung von AWS Building Blocks, insbesondere Amazon Bedrock.

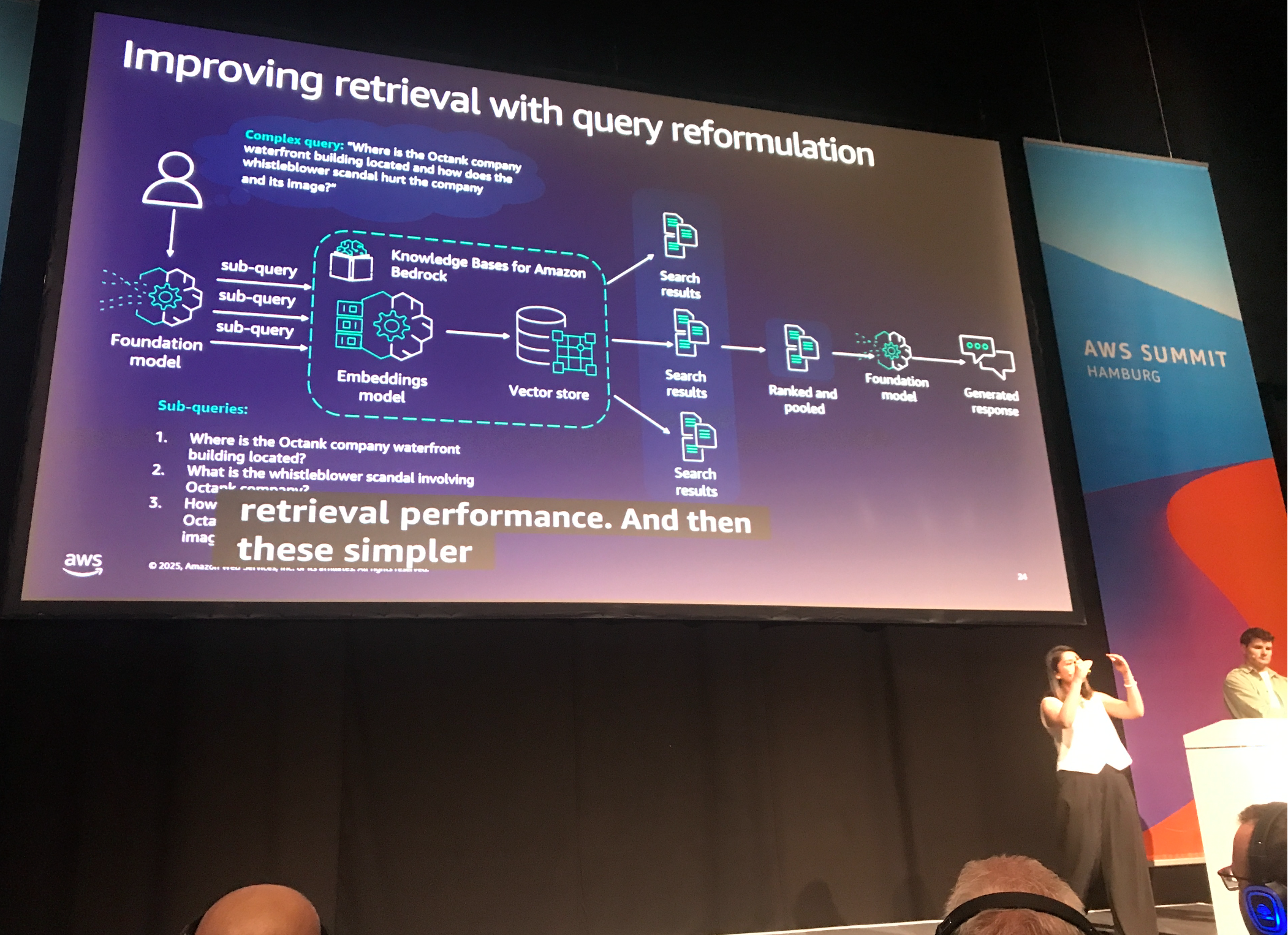

Figure 3: Vortrag „Build scalable RAG applications with Bedrock“

RAG hat sich als der heilige Gral der Wissensgewinnung in Agentensystemen etabliert. Die Technologie ist erstaunlich weit fortgeschritten. In einem Gespräch mit den Referenten des Vortrags „AI Power Search“ von KWS und Adastra erfuhr ich, welche Optimierungsmaßnahmen in einem RAG-basierten System für wissenschaftliche Artikel am erfolgreichsten waren:

- Input-Pipeline-Optimierung: Requests werden überarbeitet, verbessert und parallelisiert

- Intelligentes Chunking: Semantisches Chunking kann die RAG-System-Leistung erheblich steigern

- Hybrid-Suche: Amazon OpenSearch wird als Vektordatenbank eingesetzt und kombiniert Vektorsuche mit klassischer Volltextsuche

Amazon Bedrock bietet mittlerweile ein sehr ausgereiftes System mit zahlreichen Building Blocks für KI-basierte Lösungen. Die Kehrseite: der unvermeidbare Vendor-Lock-in.

5. Entwicklungstools der nächsten Generation

Neben dem Amazon Bedrock Flow Builder stand Amazon Q Developer im Mittelpunkt der Entwicklertools. Die Integration von MCP-Servern ist momentan nur in der CLI-Version verfügbar, aber AWS stellt bereits eine umfangreiche Sammlung von MCP-Servern auf GitHub zur Verfügung, die primär Amazon-Technologien betreffen.

Figure 4: Integration von MSP Server in der Amazon Q CLI

Was ich spannend finde: Öffentliche MCP-Server lassen sich ebenfalls einbinden, und ich erwarte, dass dies der nächste große Hit im Bereich Agentic Workflows wird. In Zukunft wird es wahrscheinlich keinen Service mehr geben, der nicht auch als MCP-Server angeboten wird und damit von künstlicher Intelligenz bedienbar ist.

Obwohl fast alle Beiträge der Geschäftspartner agentische Workflows und ausgefeilte RAG-Lösungen enthielten, war der Aspekt der MCP-Server noch sehr vereinzelt zu finden – ein Zeichen dafür, wie neu und zukunftsweisend diese Technologie ist.

6. Amazons Software-Entwicklungsprozess: Ein Blick hinter die Kulissen

Ein besonders interessanter Vortrag beleuchtete Amazons internen Software-Entwicklungsprozess. Das Konzept der „Zwei-Pizza-Teams“ – also Teams, die so klein sind, dass zwei Pizzen für alle reichen – fand ich spannend. Diese Teams haben vollständige Freiheit bei der Wahl ihrer Tools und Methoden, sind aber gleichzeitig engmaschig in Verantwortlichkeiten eingebunden.

Das Ganze ist eingebettet in umfassende Automatisierung auf verschiedenen Ebenen der CI/CD-Pipeline. KI wird massiv eingesetzt für:

- Code-Entwicklung und -Generierung

- Code-Migration

- Sicherheitslücken-Scanning

- Code-Qualitätsprüfung

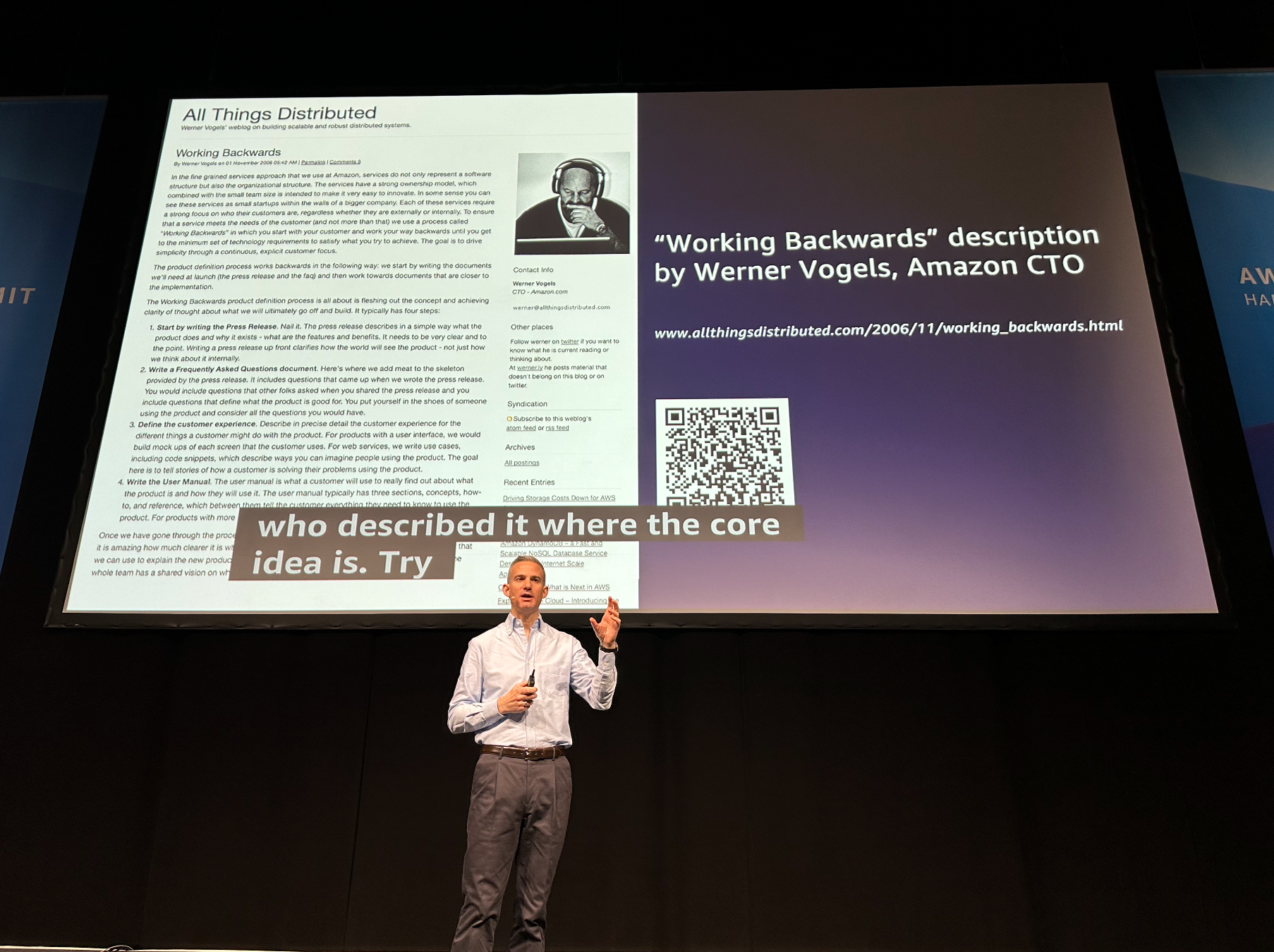

Interessant war der Verweis auf Werner Vogels Artikel „Working Backwards“ – ein Ansatz, der Kundenzentriertheit in den Fokus stellt und Produkte ausgehend von Kundenanforderungen entwickelt.

Figure 5: Verweis auf den Blog Artikel von Werner Vogel im Vortrag über Amazon’s Entwicklungsprozesses

Die hohe Produktivität entsteht durch eine Kombination aus dichter Prozess- und Ergebnisüberwachung einerseits und hoher Automatisierung plus massivem KI-Einsatz andererseits.

7. Die gesellschaftliche Dimension: Verpasste Chance

Amazon gehört zweifellos zu den Unternehmen, die KI-Innovation massiv vorantreiben und davon profitieren. Generative KI wird unser Zusammenleben und Arbeiten spürbar verändern. In diesem Kontext hätte ich mir gewünscht, dass Amazon Verantwortung übernimmt und diesen Aspekt in die Konferenz integriert.

Es gab nur einen Vortrag, der sich entfernt damit beschäftigte: „Gen AI in the workplace: productivity, ethics, and change management“. Dieser beleuchtete die Auswirkungen von KI auf verschiedene Berufe und versuchte Antworten darauf zu geben, wie man KI-Entwicklung in Unternehmen integriert.

Die Antwort auf Widerstände in der Belegschaft war enttäuschend und kreiste um die Bereitstellung von „KI-Playgrounds“. Der Angst vor Arbeitsplatzverlust wurde mit einem Zitat von Scott Galloway begegnet: „People are worried that AI is going to take their job? No, someone who understands AI is going to take their job.“

Gleichzeitig wurde von „Upskilling“ und „Rehiring“ gesprochen – also dem Austausch von Belegschaftsteilen, die den Qualifikationssprung nicht schaffen. Das hinterlässt bei mir einen bitteren Beigeschmack, gerade für diejenigen, die sich mit den neuen Anforderungen schwertun.

8. Persönliche Reflexion und Ausblick

Das AWS Summit war eine beeindruckende Demonstration modernster Computer- und KI-Technologien. Es zeigte mir, wie weit und tief KI bereits in Unternehmen eingedrungen ist und wies auf neueste Trends hin. Gleichzeitig wurde deutlich, dass die soziale Verantwortung eines profitorientierten Unternehmens erwartungsgemäß sehr kurz kommt.

Für mein eigenes Private-AI-Projekt ergaben sich wichtige Erkenntnisse:

- Die Relevanz datensparsamer Lösungen steigt, da viele Unternehmen noch keine klare KI-Strategie haben

- RAG-Technologien sind ausgereifter als gedacht

- MCP-Server werden das nächste große Ding in der Agentic-Workflow-Entwicklung

- Die Kluft zwischen KI-versierten und traditionellen Unternehmen wird größer

Als Cloud Solution Architect mit einem Jahr intensiver GenAI-Erfahrung fühlte ich mich bestätigt in meiner Einschätzung, dass wir am Beginn einer fundamentalen Transformation stehen. Die Technologie ist da, die Building Blocks sind verfügbar, und die frühen Adopter ziehen bereits davon.

9. Praktische Erkenntnisse und Ressourcen

9.1. Wichtigste technische Trends:

- Multi-Agenten-Systeme werden Standard in Enterprise-KI-Implementierungen

- RAG-Optimierung durch semantisches Chunking und Hybrid-Suche

- MCP-Server als Game-Changer für Agentic Workflows

- Amazon Bedrock als umfassendes KI-Building-Block-System

9.2. Relevante Links und Tools:

- Amazon Bedrock Agents – Umfassende Agent-Orchestrierung

- Amazon Q Developer – KI-gestützter Code-Assistent

- AWS MCP Server Collection – Sammlung verfügbarer MCP-Server

- Werner Vogels „Working Backwards“ – Customer-Centric Development

- Blog Artikel über mein Private-AI Projekt – Open-Source Projekt für eine daten-sparsame Chat Applikation.

9.3. Workshop-Erfahrungen:

- Bedrock Agent Flows bei Freenet – Grafische Agent-Orchestrierung

- Amazon Q Developer bei Moia – MCP-Server Integration in der Praxis

- Live-Konfiguration von S3-Analyse-MCP-Server in 30 Minuten

Das AWS Summit Hamburg 2025 war nicht nur eine Konferenz – es war ein Kompass für die Zukunft der KI-gestützten Softwareentwicklung und ein Weckruf für alle, die diese Transformation noch nicht ernst genug nehmen.